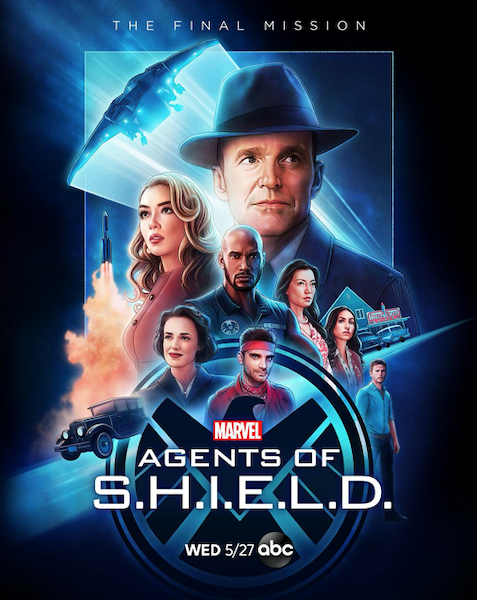

《神盾局特工S7》:最终季回归漫威宇宙,拯救九头蛇!

在《神盾局特工》第六季的时候,我们就已经知道第七季将会是最终季。而第六、七两季都被缩短至了13集。也许这一路它磕磕绊绊走来,确实已后继无力,但当这一天真的就近在眼前的时候,曾对它的不满、嘲讽都淡去了,心中只留下了不舍和眷恋。

曾经,它借着《复仇者联盟》的东风,一飞冲天,后来却风雨飘摇,每一季都在努力调整策略,甩掉“联动”双刃剑,脱离MCU主世界断尾求生,从而能够尽情地自由发挥,贡献出了无穷的脑洞和精彩的创意。

和所有长寿剧集一样,看到后来,我们总是在看情怀,看那些陪伴我们走过漫长岁月的人们,看他们被血虐,但总能在黑暗中迎来光明。

第一季的全家福

他们已经上过天入过地,去过未来、外太空、虚拟世界,那他们接下来将要去哪里呢?那当然是——过去啊!

上一季结尾,神盾局灯塔被激进派的长生人攻破,几乎全军覆没。全新造型的西蒙斯风风火火地接走了刚平息了尖叫鸟事件,被两只毁天灭地的外星怪物虐得惨兮兮的迈克、黛西等人。和风号焕然一新而且全面升级,只是菲兹又又又不见了。

西蒙斯话中有话,却谁也无法理解,在众人一脸懵逼的情况下进行了时空跳跃,一下子把他们带到了30年代的纽约(禁酒令实行期)。

这一脑袋问号终于在本季第一集得到了解答。原来是长生人在继续搞事情,他们明明是上一季家园被毁的受害者,却完全没有同理心,反过来破坏别人的家园想要夺取地球。

他们那些机器人脑壳认定这一计划的最大阻碍就是神盾局,干脆来了一招釜底抽薪,直接想从根源上抹去神盾局的存在。于是他们时间跳跃到1931年,想要刺杀某个“关键人物”。

古早的1931年,加上事关神盾局的整个历史发展脉络。所以神盾局需要一位精通历史的“向导”和分析家。没错,时代在召唤,那个人他又回来了!

专业复活哪家强?神盾特工科尔森。是在下的眼泪不值钱!

他在《复仇者联盟》电影中牺牲,通过塔希提计划复活。第五季又一次死去,留下“绝不要再次复活我”的遗言,第六季以黑化错乱版秃森回归,还是个六亲不认的大boss,再舍不得也要干掉他啊!

到了第七季,不,其实在第六季末尾我们就知道,他以生化机器人的身份又一次回到了他的孩子们身边。有了科学组、框架、长生人硬件的强强联合,分分钟还你一个全须全尾的寇森。嗯,我们寇森现在是个字面意思上的铁憨憨了,刀枪不入那种。

性格嘛,当然还是我们熟悉的那位软糯小天使,但他要在十秒内接收自己死而复“生”、机器人以及错过的两年时光的信息,难免陷入混乱。而他最思念的梅因为在上一季以一具肉身单挑两个怪物,身负重伤,目前沉睡在冷冻仓中,由伊诺克进行“修复”(集末有惊吓~)。

嗯没错,可可爱爱的长生人伊诺克正式加入神盾局,成了和风号上的吉祥物和西蒙斯可爱又迷人的左膀右臂。而就是他的提议,让菲兹西蒙斯再次分开,各自踏上拯救神盾局的征程。我们眼前的这位和上一季造型完全不同的西蒙斯,很有可能是来自于未来。

现在的节奏完全是科学组在主导,看着他们一路成长一路虐,从小萌新锻炼成现在能够独撑大局的战士,真是不由得流下了欣慰的泪水。

其他几位就没任何休息时间了,他们必须马不停蹄地在30年代的纽约阻止长生人。于是我们看到了复古风的寇森、黛西、迈克和迪克,以及他们因三观不合和“古人”的各种磕磕碰碰。小道消息说第七季可能会和《特工卡特》联动诚不欺我!这时正好是大萧条时期,各种时代梗层出不穷。

悠悠因为被尖叫鸟寄生过,目前属于外星污染源暂时不能外出(内涵了一下隔离)。不过她额外得到了一双仿生手臂。她终于可以告别冰冷的机械手臂,能够拥有真实的触感,去触碰自己、爱人、朋友,和这个世界。

寇森在一件“无脸案”中发现了蛛丝马迹,追查之下他们认定长生人打算刺杀当时还是纽约州州长的罗斯福。因为他在次年便会当选美国总统。再过几年他会成立神盾局前身——战略科学军团。只要没有他,就不会有神盾局。

作为罗斯福的忠实迷弟,虽然一开始寇森对自己的生化人新身份还不情不愿,但知道自己将要救的是罗斯福之后,整个人就变得容光焕发起来,还说起了关于时代的各种冷笑话。在和长生人打斗时还发现了自己武力值爆棚,不由得露出了喜悦的笑容。

刺杀罗斯福这一计划感觉合情合理,但脑回路清奇的长生人并不这么认为。伟大的罗斯福只出来打了个酱油,真正的目标却是个无名之辈——地下酒吧的打工仔弗莱迪。他的老板居然是神盾局王牌凯尼格双子的祖辈(再见到这个胖子好亲切啊!)。

来,曾经抱怨过神盾局脱离了漫威主宇宙的小伙伴们有福了!比起罗斯福,长生人认为对神盾局的诞生更为重要的,毫无疑问是终极冤家——九!头!蛇!而这个无名小辈就是九头蛇创始人的父亲。

绕了一个大圈,wuli神盾局终于又想起了前几季被九头蛇支配的恐惧。跨越时空,神盾局要来拯救九头蛇了!原来九头蛇是神盾局帮着成立的啊,真是活久见,还愣着干嘛?赶紧鼓掌撒花呀!

不得不说,虽然神盾局一路走来砍掉了无数让人心心念念的伏笔和分线,但最后这个圈圆得实在是牛逼,世间万物相生相克、相辅相成,还有比“终点就是起点”更令人热血沸腾的吗?

七季,七年。

我们看到斯凯成长为黛西,从路人成为主角;看到菲兹西蒙斯用他们的爱和强大的信念对抗宇宙的诅咒;看到寇森一次次离开又一次次回来,始终不舍如同他孩子一般的神盾局;看到梅一骑当千却在爱人面前露出柔软;看到无数次的旧人离开、新人露面;看到每次危机化解的代价是很多令人意难平的别离;看到他们一直被虐,一直战斗,这一路走得艰难。

作为最终季,加上时间跳跃这条主线,很可能编剧会以多个时间段的形式,去回顾或者致敬以前的那些人和那些事,并和漫威宇宙的其他剧联动。那些曾以为再也见不到的人也会回来。也许,所有的意难平都会在这一季中得到念念不忘的回响。

让我们拭目以待,这也许就是我们坚持了那么久所等来的——最完美的终点。

如果说这七年来,都是它陪伴着我们,那么在这剩下的短短数月中,换由我们陪着它走完剩下的路。等到离别之日真的到来那天,我们再好好告别。

相关资讯

杨紫琼星际迷航大电影抢鲜看;尼根继续闯荡行尸宇宙

杨紫琼(Michelle Yeoh)主演的《星际迷航:31区》(Star Trek: Section 31)电影迎来首款预告,明年1月24日上线流媒体Paramount+。届时Philippa Georgiou女皇加入了星际舰队的一个秘密部门,肩负着保护星球联邦的任务。与此同时,她也必须面对自己过去的罪恶。欧玛瑞·哈德威克(..

《太太太厉害》首播,隋棠这次不吃兔兔,化身战斗系美女特工

11月4日,电视剧《太太太厉害》已经可以在视频平台前两集观看。这部电视剧由曾沛慈、隋棠、杨祐宁等演员主演,讲的则是我国台湾省某山区的“谍战特工”故事。这个地域环境之下,讲如此违和的特工故事,让这部电视剧具备着独特的味道感。在这部电视剧当中,曾沛慈和杨祐宁饰演一组..

尾鱼IP再征战,腾讯视频能否成功打造“尾鱼宇宙”?

文 | 眸娱继动漫、网络大电影之后,腾讯视频将再次对尾鱼的奇情悬疑小说《三线轮回》将进行电视剧改编。10月21日,根据《三线轮回》改编的新剧《三线谜回》在云南大理开机,由孟子义、王弘毅两位青年演员担纲主演,但相比于两位二搭的演员,尾鱼似乎才是整个项目最大的看点,就连..

脱口秀宇宙不能没有付航

付航在《喜剧之王单口季》杀青之际一举夺冠,官宣已婚的消息令人无从反应。当众人还在笑 “猴” 时,这 “猴” 已婚了。 以他的人生视角下重叙 “普信男” 的经历,学生时代模仿 “忧郁男孩” 的表白攻略被骂,学习《流星花园》花泽类..

庵野秀明将制作“始祖”动画《宇宙战舰大和号》

近日,据电影《新世纪福音战士》系列导演庵野秀明透露,《新世纪福音战士》的制作公司khara已经取得了《宇宙战舰大和号》的全新电影版制作版权,庵野秀明将参与该项目,计划于2025年开始制作。原作漫画《宇宙战舰大和号》的作者为日本著名漫画家松本零士,同样由他本人执导的动画..

上映2小时,热度第一,没想到,“捉刀人宇宙”又打出了一副王炸

谢苗和释小龙,是上世纪90年代香港电影辉煌时期最火的两位童星,两人的年纪相差4岁,却同在1994年出道。谢苗由王晶从北京的少年宫武术队发掘,参演李连杰主演的电影《新少林五祖》;释小龙则由朱延平导演发掘,主演其执导的电影《笑林小子》。其后两人皆参演了多部经典动作片,在..

“狼人”即将大闹怪物电影宇宙

环球影业旗下的怪物新作《狼人》(Wolf Man)将于2025年1月17日上映,发布先导预告,本片由克里斯托弗·阿波特(Christopher Abbott)和朱莉娅·加纳(Julia Garner)倾情主演,《隐形人》(The Invisible Man)的雷·沃纳尔(Leigh Whannell)掌舵。在父亲失踪并被推定死亡后,男..

漫威灭霸要乱入DC宇宙?粉红海王开启真人版《我的世界》

昔日的“灭霸”乔什·布洛林(Josh Brolin)近日被曝有望加盟HBO旗下的“绿灯侠”(Green Lantern)主题真人剧,他被邀请出演Hal Jordan一角,但截至9月5日还没有接受。如果布洛林拒绝的话,马修·麦康纳(Matthew McConaughey)和伊万·麦克格雷格(Ewan McGregor)也在候选名单..

漫威宇宙新角色莫比亚斯中字特辑,你知道他是谁吗?

莫比亚斯是谁?由索尼影业打造的《暗夜博士:莫比亚斯》官方发布中字预告特辑!除了超多的新镜头,“少爷”莱托也现身其中围观中解读关于莫比亚斯在漫威宇宙中的重要身份!“一个前所未有的漫威角色,将带来无限可能。”本片由奥斯卡最佳男配角得主杰瑞德·莱托饰演拥有独特力量的..

《阿加莎》新剧揭秘:探索漫威宇宙中的神秘与真相掩盖之谜

近日,备受期待的漫威宇宙新剧《阿加莎》正式上线。该剧讲述了阿加莎这个角色的故事,同时也揭示了一些公众不知道的关于漫威宇宙的秘密和真相。本文将为大家带来这部剧的详细介绍。首先我们来认识一下阿加莎这个人物。她首次出现在漫威漫画中,作为巫师和恶棍。在漫威电影宇宙中,..

詹姆斯·冈恩发布了首批新DC宇宙(DCU)项目

近期,华纳兄弟旗下的DC漫画电影宇宙(DCEU)的发展方向发生了重大变化。知名导演詹姆斯古恩在推特上宣布了他的新DC宇宙(DCU)的首批项目,这让很多DC粉丝有种收到圣诞礼物的感觉。据悉,冈恩将执导一部游戏改编电影,名为《自杀小队:游戏之夜》(自杀小队:杀死正义联盟)。该..

乐高和星球大战?混搭风格-奇异宇宙

迪士尼+发布了即将上映的万圣节特别动画电影《乐高星球大战:恐怖故事》(Lego Star Wars Terrifying Tales)的预告片,该动画将于10月1日在流媒体上首映。这个略显“诡异”的混搭带领观众进入一个围绕乐高系列中受大家喜爱的角色徐徐展开的奇异宇宙。特别篇的主要故事是发生在《..

《尚气与十环传奇》对漫威宇宙意味着什么?关于这位最新超英你需要知道的7件事

【警告】 本文包含《尚气与十环传奇》剧透。本片于2021年9月2日港澳台地区上映,3日在美国上映。这部漫威超英电影选择先行在华人地区上映,以漫威漫画角色“尚气”为主角,它是首部以亚裔超级英雄为主角的影片。由于尚气是漫威电影宇宙的“新人”,即使是老粉可能也了解不多,所以..

DC宇宙《蝙蝠侠:英勇无畏》:探索新蝙蝠侠角色的设想与创新

DC宇宙《蝙蝠侠:勇敢无畏》:探索新蝙蝠侠角色的想法和可能性最近,DC宇宙的粉丝们对即将上映的电影《蝙蝠侠:勇敢无畏》议论纷纷。该片由马特里夫主演,讲述了蝙蝠侠与迈克尔博士联手对抗黑暗势力的故事。除了马特里夫饰演的蝙蝠侠之外,不少粉丝也开始期待电影中可能出现的新蝙..

《蜘蛛夫人:超感觉醒》之后,西德妮·斯威尼是否将重返漫威电影宇宙?-漫威资讯-漫威电影

在《蜘蛛夫人:超感觉醒》中首次饰演蜘蛛女之后,西德妮·斯威尼对于自己是否愿意出现在漫威电影宇宙中敞开了心扉。经过数年的开发,《蜘蛛夫人:超感觉醒》这部电影于今年上映,成为2024年首部上映的漫画改编电影。然而,该片受到了负面评论和票房不佳的影响,使得索尼影业对《蜘..

《复仇者联盟6:秘密战争》中的钢铁侠回归,唐尼将扮演多元宇宙版本?-漫威资讯-漫威电影

尽管罗伯特·唐尼在2019年离开了漫威电影宇宙(MCU),但他一直被认为会在2027年的《复仇者联盟6:秘密战争》中回归。然而,这次的回归并不是观众所熟知和喜爱的那个版本。唐尼在2008年的《钢铁侠》中首次饰演托尼·斯塔克,并在之后的十年里引领了MCU的发展,标志着他在经历了199..

《神奇四侠》重启版:探索漫威宇宙中的神秘负空间-漫威资讯-漫威电影

《神奇四侠》重启版已经获得了一个全新的漫威电影宇宙粉丝预告片,同时引发了关于这部电影的一个有趣的漫威理论。自2019年圣地亚哥漫展上宣布以来,《神奇四侠》终于离成为现实更近了一步。作为mcu的第6阶段开篇之作,《神奇四侠》将聚焦于这些标志性英雄,他们最终将成为以复仇者..

阿盖尔:神秘特工下载百度云资源「1080p/高清夸克网盘」云网盘

亨利卡维尔在新电影“阿盖尔:神秘特工”中讨论了他的角色的整体外观,包括他奇怪的发型。即将上映的动作喜剧导演王牌特工马修沃恩主演:卡维尔饰演名为阿盖尔的主角,该角色由隐居作家埃莉康威(布莱) 达拉斯霍华德创作的虚构人物,《自从2022年11月“亨利卡维尔”在《阿盖尔:神..

昨天泄露版《蜘蛛侠:英雄无归》预告全网被删,今天正式发布了!多元宇宙开启

他最信赖敬重的导师——钢铁侠死了,第二位导师背叛了他,他的身份被揭穿,而他身上还背负着责任,彼得·帕克在错综复杂的生活中面临着艰难的时刻,似乎一切都变得更混乱了。索尼和漫威刚刚放出了《蜘蛛侠:英雄无归》的首支预告片。漫威世界现在非常繁忙,刚刚冒险进入了旺达幻视..

黑豹变星爵,美队变丧尸,蜘蛛侠成奇异博士……漫威在多重宇宙主题上疯狂输出

文章链接:https://mp.weixin.qq.com/s/tLYvDVSd8B76XWsvH41hsg不久前,《洛基》中的神圣时间线被希尔维终结(《洛基》传送门),标志着漫威第四阶段真正进入宇宙层面,漫威开始了在多重宇宙主题上的疯狂输出。佩姬成为卡特队长,黑豹变身星爵,美队不打血清变丧尸,幻视化身奥创..

漫威新片《假如…?》今天上线,从另一个视角探讨漫威宇宙大

漫威新片《假如…?》今天(8月11日 周三)上线Disney+,烂番茄新鲜度90%,本剧已续订第二季,每季各9集。直到下一部漫威电影《尚气与十环传奇》(Shang-Chi and the Legend of the Ten Rings)9月上映之前,这部动画电视剧或许可以满足漫威迷们的“空虚”,这部连续剧将以新的视..

星战宇宙最有魅力的赏金猎人奶爸又回来了!

2019年可能是星战迷心态最复杂的一年。这一年,谢天谢地《星球大战9:天行者崛起》终于用匪夷所思的结局给狗尾续貂的“《星球大战》后传三部曲”画下了句号,现在只等记忆消退观众们快点忘记这个系列之耻,或是茶余饭后打趣鞭尸。同样是这一年,首部《星球大战》真人衍生剧集《曼..

阿盖尔:神秘特工下载百度云网盘(夸克网盘HD高清)在线分享费资源

经过三年的等待,导演马修范恩终于带着他的新动作惊悚片《阿盖尔:神秘特工》回归。然而,问题仍然存在:“阿盖尔:神秘特工”需要获得多少票房才能成功超出预算?自2000 年代初以来,马修范恩(MatthewVann) 一直参与各种流行电影的制作,但他最新的成名作品是他的动作系列片喜剧..

《福尔摩斯小姐》打破第四面墙,开启推理新宇宙

本片改编自南希·斯普林格的《福尔摩斯小妹探案》,是福尔摩斯系列的衍生作品,传奇影业投资制作,受到疫情的持续影响,电影市场一片低迷,传奇不得不把本片卖给网飞,改在网络上映。纵观近几年的传奇影业,除了和华纳、东宝联手打造的“怪兽电影宇宙(MonsterVerse)”,像《环太..

《异星灾变》——将福音撒向宇宙

“科幻大佬”雷德利·斯科特转战小荧幕,执导HBO科幻新剧《异星灾变》,继续着他钟爱的科幻、怪物题材。《异星灾变》现已播出,HBO非常痛快,一次更新了3集,科幻粉丝们不容错过。首先,笔者吐槽一下,本剧的中文译名和英语《Raised by Wolves》牛头不对马嘴,完全不搭嘎,仅凭剧..

《神盾局特工》: 七年梦醒,终须一别

这周我们将迎来《神盾局特工》大结局两集联播。终于,还是到了要说再见的时候了。七年,梦一场。还记得第一季开始的时候吗?“英雄和怪物,他们就在我们身边。世界满是奇迹,我们无法解释看到的一切,但是我们眼界大开。当不可能的事发生了,你们打算怎么办?”——这就是梦开始的..

剧版“王牌特工”?差得远呢!

聊《少年间谍亚历克斯》之前我想先聊聊它的“精神前作”《王牌特工》。2014年马修·沃恩的漫改电影《王牌特工》横空出世,在一众超级英雄电影中杀出重围,一洗漫画原著的坎坷命运,以“少年特工”的形式令逐渐边缘化的特工电影重新引发热议,甚至商业上的成功催生出续集以及本定于..

“漫改三连”成功的背后,《少年白马醉春风》总制片人周照中受访,揭秘少年感的打造与武侠新宇宙构建

半岛全媒体记者 王悦从《少年歌行》到《异人之下》,再到近日收官的《少年白马醉春风》,优酷凭借“漫改三连”的成功,颠覆了大众对漫改剧的固有印象。想象力、奇观、热血、少年感,这些元素构成了漫改剧的关键特质。作为阿里大文娱优象工作室总经理兼《少年白马醉春风》的总制片..

《蝙蝠侠》监制:“蒂姆·波顿的布鲁斯·韦恩让漫威电影宇宙成功!”

据蝙蝠侠电影制片人称,导演蒂姆·波顿(Tim Burton)的“布鲁斯韦恩”,导致了漫威电影宇宙MCU的成功!导演蒂姆·波顿执导了2部蝙蝠侠电影,为1989年的《蝙蝠侠》,以及1992年的续集《蝙蝠侠归来》,而迈克尔·基顿(Michael Keaton)演出蝙蝠侠布鲁斯韦恩。近日在《Traversing t..

奇异博士2:疯狂多元宇宙在线免费观看【1280P超高清中英字幕】高清版资源

漫威宇宙近来推出的影集《汪达幻视》、《洛基》、《鹰眼》等都大受欢迎,推动迪斯尼制作更多角色影集,去年宣布将推出《汪达幻视》里重要角色女巫阿嘉莎哈克尼斯(Agatha Harkness)的外传个人影集为《阿嘉莎:哈克尼斯家族》(暂译,Agatha: House of Harkness),由女星凯瑟琳哈..