快手出品!DragAnything:拖动锚点精准控制视频物体和镜头运动

划重点:

⭐️ 快手科技联合浙江大学研究团队提出了 DragAnything 方法,利用实体表示实现了对任何物体的运动控制。

⭐️ 对比现有的运动控制方法,DragAnything 在用户友好性、对象多样性和多对象控制方面具有优势。

⭐️ 在实验中,DragAnything 在 FVD、FID 和用户调查方面取得了 state-of-the-art 的表现,尤其在对象运动控制方面超过了以前的方法。

快手科技联合浙江大学、新加坡国立大学表演实验室研究团队提出了一种名为 DragAnything 的新方法,通过实体表示实现了对任何物体的运动控制。

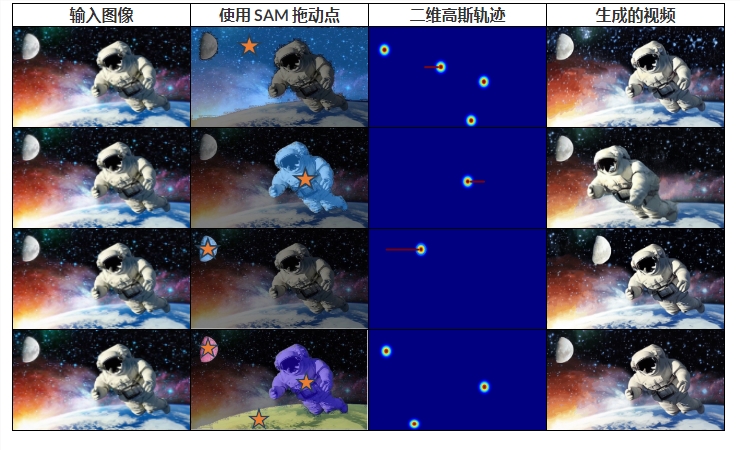

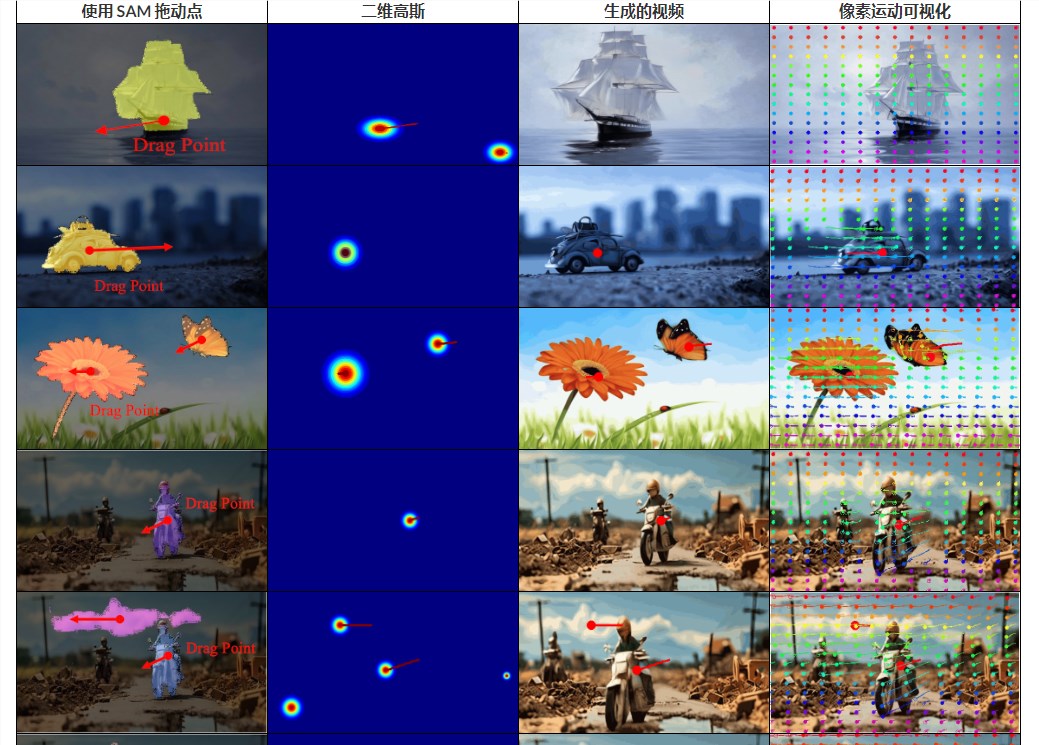

DragAnything可以实现用户轨迹交互,并具有SAM功能。包括可以精确控制物体的运动,生成高质量视频,用户只需在交互过程中绘制一条轨迹。另外DragAnything可实现对前景、背景和相机等不同元素的多样化运动控制。

研究团队通过分析发现,DragNUWA 的像素运动轨迹并不能很好地代表物体的整体运动,因为单个点无法表示整个实体。此外,他们还观察到,在 DragNUWA 合成的视频中,距离拖动点较近的像素展示了更大的运动,这并不符合他们对物体整体运动的期望。因此,他们提出了 DragAnything 方法,通过实体表示实现了对整个物体的运动控制,解决了这些问题。

与现有的运动控制技术相比,DragAnything 有几个显著的优势:

首先,基于轨迹的操作方式对用户更友好,尤其是在获取其他辅助信号(如遮罩、深度图等)较为繁琐时。用户只需在互动中绘制一条线(即轨迹)即可。

其次,DragAnything实体识别技术能够处理任何对象,这意味着它可以控制包括背景在内的各种实体的运动。

最后,这种实体识别技术还可以同时对多个对象实现不同的运动控制。

大量实验表明,该技术在 FVD、FID 和用户体验研究方面均达到了行业领先水平,特别是在对象运动控制方面,该方法比之前的技术(例如 DragNUWA)在人类评估中提高了26%。

DragAnything 方法在视频生成领域取得了显著进展,为实现对任何物体的精确运动控制提供了新的思路和方法。

产品入口:https://top.aibase.com/tool/draganything

更新于:9个月前