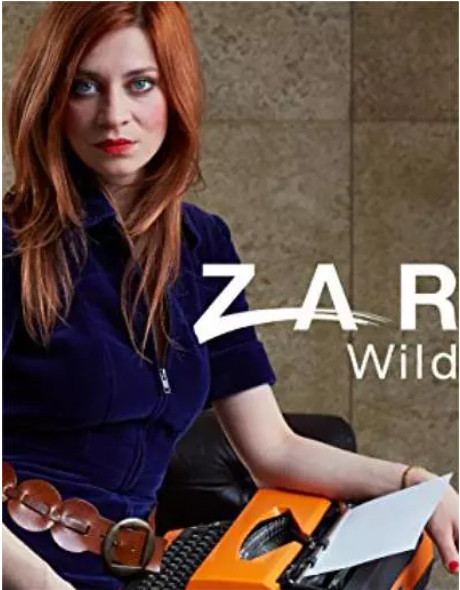

[ 德剧 ]《狂野岁月》

2024-12-22 10:19

1973年德国汉堡市,女权主义活动家兼作家Zarah Wolf被一家大出版社雇用。在这个以男性占主导地位的地区,她尝试为性别歧视、堕胎等男女不平等的行为话题发声,但往往因此而身陷囹圄。出版商的女儿Jenny Olsen却一直支持着她的信念,最终她们相爱了。在这个狂野的年代,度过了狂野岁月,正如女主的名字Zarah Wolf,谁说女子就不如男子?勇敢的孤狼闯出了自己的一片新天地!作为一部

- 原名:Zarah- Wilde Jahre

- 地区:德国

- 语 言:德语

- 首播:2017-08-24 周四

- 电视台:其他

- 类型:剧情/爱情/励志

- 制作周期:补剧中

- 翻译:亿万同人字幕组

- IMDB:7.2分/157人评tt6756488

- 編劇:Volker A. Zahn

- 主演:托本·利布雷希特 / 克劳蒂亚·艾辛格 / 思文佳·永

相关影视