A16Z最新发布:下一代皮克斯,AI 会如何融合电影和游戏?

故事是人类体验的核心——我们通过故事来理解世界、找到意义并与他人建立联系。在过去的一个世纪里,我们最喜爱的许多故事都是通过技术变革实现的。20世纪30年代,迪士尼发明了多平面摄像机,并率先制作了声音同步的全彩动画片——最终催生了开创性的动画电影《白雪公主和七个小矮人》。

漫威和 DC 漫画在20世纪40年代声名鹊起,被称为“漫画黄金时代”,这得益于四色轮转凸版印刷和胶版印刷的普及,可用于大规模印刷漫画。该技术的局限性(低分辨率、有限的色调范围、在廉价新闻纸上进行基于点的印刷)创造了我们至今仍能识别的标志性“纸浆”外观。

同样,皮克斯在20世纪80年代也占据了独特的地位,充分利用了新技术平台——计算机和3D 图形。联合创始人 Edwin Catmull 是纽约理工学院计算机图形实验室和卢卡斯影业(Lucasfilm)的早期研究员,开创了基础 CGI 概念,后来制作了第一部完全由计算机生成的长片《玩具总动员》。皮克斯著名的图形渲染套件 Renderman 迄今已在500多部电影中使用。

在每一次技术浪潮中,早期的原型都是新奇事物,后来成为新一代创作者引领的深度故事叙述的新形式。今天,我们相信下一代皮克斯即将问世。生成式人工智能正在推动创意故事叙述的根本性转变,使新一代人类创作者能够以前所未有的新颖方式讲述故事。

具体而言,我们认为下个世纪的皮克斯不会通过传统电影或动画出现,而是通过互动视频。这种新的故事叙述形式将模糊视频游戏与电视/电影之间的界限——将深度故事叙述与观众主体性和“游戏”融合在一起,开辟一个广阔的新市场。

在之前的文章中,SenseAI 也为大家介绍了几款早期 AI 影视产品的构想,《深度|AI+视频娱乐平台大盘点,谁会成为下一个“Netflix”》,感兴趣的读者可以补充阅读~

01.

游戏——现代故事叙述的前沿

当今有两大浪潮可能会加速新一代故事讲述公司的创建:

1、消费者转向交互式媒体(而非线性/被动媒体,例如电视/电影)

2、生成式人工智能推动的技术进步

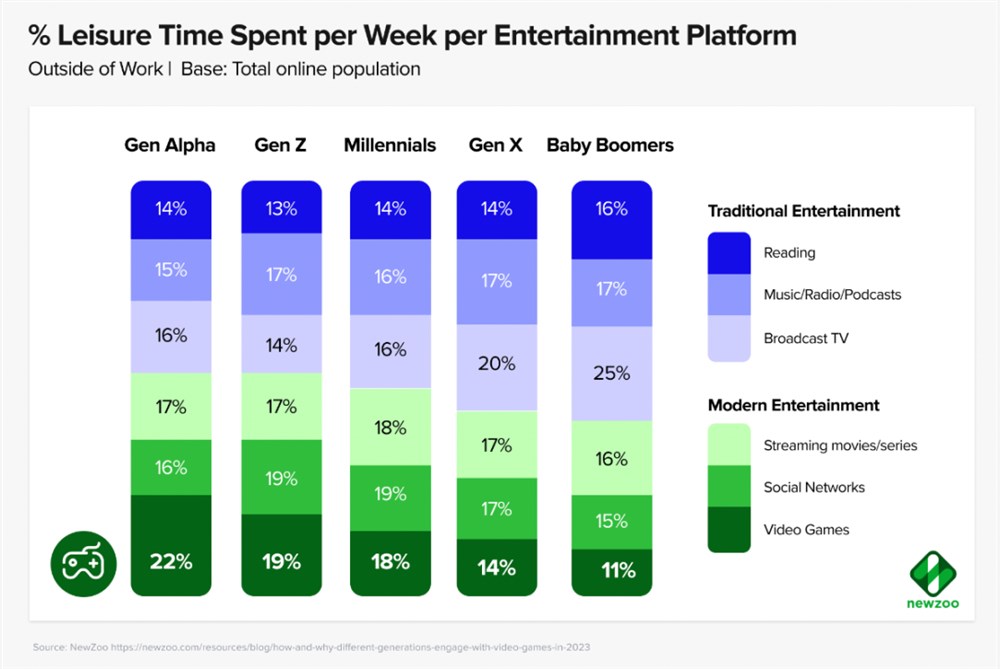

在过去30年中,我们看到了消费者的稳步转变,游戏/互动媒体在每一代人中都变得越来越受欢迎。对于 Z 世代及更年轻的一代来说,游戏现在是他们消磨空闲时间的首选方式,超过了电视/电影。

2019年,Netflix 首席执行官里德·哈斯廷斯 (Reed Hastings) 在一封股东信中说道:“我们与Fortnite 的竞争(和输给)比 HBO 的竞争更激烈。”对于当今大多数家庭来说,问题是“我们在玩什么”与“我们在看什么”。

虽然电视/电影/书籍仍然承载着引人入胜的故事,但如今许多最具创新性和成功的新故事都是在游戏中讲述的。以哈利波特为例,开放世界角色扮演游戏《霍格沃茨遗产》让玩家以前所未有的沉浸感进入霍格沃茨的新生。这款游戏是2023年最畅销的游戏,发行时票房超过10亿美元,票房超过了除结局《死亡圣器第二部分》(13亿美元)之外的每一部哈利波特电影的票房。

游戏 IP 近期在电视/电影改编方面也取得了巨大成功。顽皮狗的《最后生还者》是 HBO Max2023年收视率最高的系列剧,平均每集有3200万观众。《超级马里奥兄弟》电影票房收入14亿美元,创下了动画电影史上全球首映周末票房最高纪录。此外还有广受好评的《辐射》系列、派拉蒙不太出色的《光环》系列、汤姆·霍兰德的《神秘海域》电影、迈克尔·贝的《Skibidi Toilet》——名单还有很长。

互动媒体如此强大的一个关键原因是,积极参与有助于培养对故事或世界的亲和力。全神贯注玩游戏一小时 被动看电视一小时。许多游戏也是社交性的,其核心设计中内置了多人游戏机制,最令人难忘的故事是我们创造并与亲近的人分享的故事。

通过多种方式(观看、播放、创作、分享)持续与 IP 互动,故事不再只是娱乐,而是成为个人身份的一部分。神奇的时刻是当一个人从“我看哈利波特”转变为“我是波特迷”时。后者更为持久,围绕以前可能是单人活动的内容建立身份和多人社区。

总而言之,虽然我们历史上的一些最伟大的故事都是通过线性媒体讲述的,但未来的故事将在游戏和交互式媒体中讲述——因此我们相信下个世纪最重要的故事讲述公司将在这里建立。

02.

互动视频:讲故事与游戏结合

鉴于游戏在文化领域的主导地位,我们相信下一个皮克斯将通过一种将讲故事与游戏相结合的媒体形式出现,我们认为一种有潜力的形式是互动视频。

首先,什么是交互式视频?它与视频游戏有何不同?

在视频游戏中,开发人员将一组资产预加载到游戏引擎中。例如,在《超级马里奥兄弟》中,艺术家设计了马里奥角色、树木和背景,程序员设定马里奥在玩家按下“A”按钮后精确跳跃50像素,跳跃帧通过传统图形管道渲染。这导致游戏具有高度确定性和计算性的架构,开发人员可以完全控制游戏。

另一方面,交互式视频完全通过神经网络实时生成帧。除了一组创意提示(可以是文本或代表性图像)外,无需上传或创建任何资产。实时 AI 图像模型接收玩家输入(例如“向上”按钮),并将概率推断下一个生成的游戏帧。

交互式视频的前景在于将电视/电影的可访问性和叙事深度与视频游戏的动态、玩家驱动系统相结合。每个人都已经知道如何看电视和跟随线性故事。通过添加使用玩家输入实时生成的视频,我们可以创建个性化、无限的游戏玩法——有可能使媒体资产能够留住粉丝数千小时,就像最好的玩家驱动游戏一样。暴雪的《魔兽世界》已有20多年历史,至今仍保留着约700万订阅用户。

互动视频还能实现多种消费模式——观众可以像看电视节目一样靠在电视上观看内容,也可以在移动设备或控制器上积极玩游戏。让粉丝以尽可能多的方式参与他们最喜欢的 IP 世界是跨媒体叙事的核心,这有助于增强对 IP 的亲和力。

在过去十年中,许多故事讲述者都在尝试各种互动视频。早期的突破是 Telltale 的《行尸走肉》——一款基于Robert Kirkman漫画系列的电影体验,玩家可以观看动画场景,但会在关键时刻通过对话和快速反应事件做出选择。这些选择——例如在僵尸袭击时决定拯救哪个角色——创造了故事变体,使每次游戏都具有个性化。《行尸走肉》于2012年推出,获得了巨大成功——赢得了多项年度游戏奖,迄今为止销量超过2800万份。

2017年,Netflix 还进军互动视频领域——从《猫与书》等动画开始,最终推出广受好评的《黑镜:潘达斯奈基》,这是一部真人电影,观众可以决定一位年轻的程序员如何将一本奇幻小说改编成视频游戏。《潘达斯奈基》是一部节日热门影片,吸引了大批狂热粉丝,他们制作了流程图来记录电影的所有可能结局。

然而,尽管《潘达斯奈基》和《行尸走肉》都获得了好评,但它们都面临着一个生存问题——手动创建定义该格式的无数分支故事需要耗费大量时间和成本。随着 Telltale 扩展到多个项目,他们因加班加点而闻名,开发人员抱怨他们“频繁更换和烧钱”。故事质量受到影响——《行尸走肉》一开始在 Metacritic 上获得了89分的好评,而4年后,Telltale 发布了他们最大的 IP 之一《蝙蝠侠》,但 Metacritic 上却只获得了令人失望的64分。2018年,Telltale因未能找到当时可持续的商业模式而宣布破产。

为了制作《潘达斯奈基》,剧组拍摄了250个视频片段,总长度超过5小时,以呈现电影的5个结局。据报道,预算和制作时间是标准《黑镜》剧集的两倍,剧集制作人表示,该项目的复杂性相当于“同时制作4集”。最终在2024年,Netflix 决定封存整个互动特别节目部门,转而选择制作传统游戏。

到目前为止,互动视频项目的内容成本与游戏时间成线性关系,这是无法避免的。然而,生成式人工智能模型的进步可能会让互动视频大规模发挥作用。

03.

生成模型很快就会足够快,可以实现交互式视频

图像生成模型蒸馏的最新进展令人震惊。2023年,潜在一致性模型(latent consistencymodels)和 SDXL Turbo 的发布,极大地提高了图像生成速度和效率——只需一步即可实现高分辨率渲染,而之前需要20-30步,成本降低了30倍以上。生成视频(一系列逐帧变化的一致图像)的想法突然变得非常可能。

今年早些时候,OpenAI 发布了Sora,震惊了世界。Sora 是一个文本转视频模型,可以生成长达1分钟的视频,同时保持视觉一致性。不久之后,Luma AI 发布了速度更快的视频模型 Dream Machine,可以在120秒内生成120帧(约5秒的视频)。Luma 最近分享说,他们在短短7周内就达到了惊人的1000万用户。上个月,Hedra Labs 发布了 Character-1,这是一个专注于角色的多模式视频模型,可以在90秒内生成60秒的视频,具有富有表现力的人类情感和配音(SenseAI 此前在这篇文章中介绍了Hedra,《斯坦福团队发布的AI+视频生成工具,旨在为AI角色赋予声音,获1000万美元种子轮融资》)。Runway 最近推出了Gen-3Turbo,这个模型可以在15秒内渲染10秒的片段。

如今,有抱负的电影制作人可以根据文本提示或参考图像快速生成几分钟的720p 高清视频,这些视频可以与开始或结束关键帧配对,以实现更高的特异性。Runway 还开发了一套编辑工具,可以对扩散生成的视频提供更精细的控制,包括帧内摄像机控制、帧插值和运动画笔(视频的动画部分)。Luma 和 Hedra 也将很快发布自己的创作者工具套件。

虽然制作工作流程还处于早期阶段,但我们已经遇到了几位使用这些工具创作故事的内容创作者。Resemblance AI 创作了Nexus1945,这是一部令人惊叹的3分钟二战另类历史,由 Luma、Midjourney 和 Eleven Labs 讲述。独立电影制作人 Uncanny Harry 与 Hedra 合作创作了一部赛博朋克短片。创作者们制作了音乐视频、节目预告片、旅行视频博客,甚至还有快餐汉堡广告。自2022年以来,Runway 每年都会举办一次 AI 电影节,选出10部在 AI 帮助下制作的顶级短片。

然而,要承认当前的一些限制,在叙事质量和控制方面,提示生成的2分钟剪辑与专业团队制作的2小时故事片之间仍然存在很大差距。很难从提示或图像中生成创作者想要的确切内容,即使是经验丰富的提示工程师通常也会丢弃他们生成的大部分内容。AI 视频创造者 Abel Art 表示,1分钟连贯视频的比例约为500个视频。图像一致性通常在连续视频一两分钟后开始失效,需要手动编辑——这就是为什么今天大多数生成时间限制在约1分钟。

对于当今大多数专业的好莱坞电影公司来说,扩散模型生成的视频可能在前期制作中用于故事板(Storyboard),以直观地展示场景或角色的外观,但不能替代现场工作。后期制作中,也有机会使用人工智能进行音频或视觉效果,但总体而言,与已经投入数十年的传统工作流程相比,人工智能创作工具套件仍处于早期阶段。

短期内,生成视频的最大机会之一在于推动互动视频和短片等新媒体格式的发展。互动视频已经根据玩家的选择被分成1-2分钟的短片段,并且通常是动画或风格化的,允许使用分辨率较低的镜头。更重要的是,通过 diffusion model 制作这些短片比 Telltale /Bandersnatch 更具成本效益——Abel Art 估计 Luma 制作1分钟视频的成本为125美元,相当于租用电影镜头一天。

尽管如今生成的视频质量可能不稳定,但 ReelShort 和 DramaBox 等垂直短片的流行已经证明,观众对制作价值较低的电视连续剧短片有需求。凭借数千部短小精悍的电视连续剧(如《禁忌的欲望:阿尔法的爱》),ReelShort 的下载量已超过3000万次,每月收入超过1000万美元,尽管评论家抱怨电影摄影业余且剧本公式化。

交互式视频的最大剩余技术障碍是达到足够快的帧生成速度,以便动态生成内容。Dream Machine 目前每秒生成约1帧,在现代游戏机上发布的游戏可接受的最低目标是稳定的30FPS,其中60FPS 是黄金标准。借助PAB(Pyramid Attention Broadcast)等技术进步,某些视频类型的帧生成速度可以提高到10-20FPS,但仍然不够快。

04.

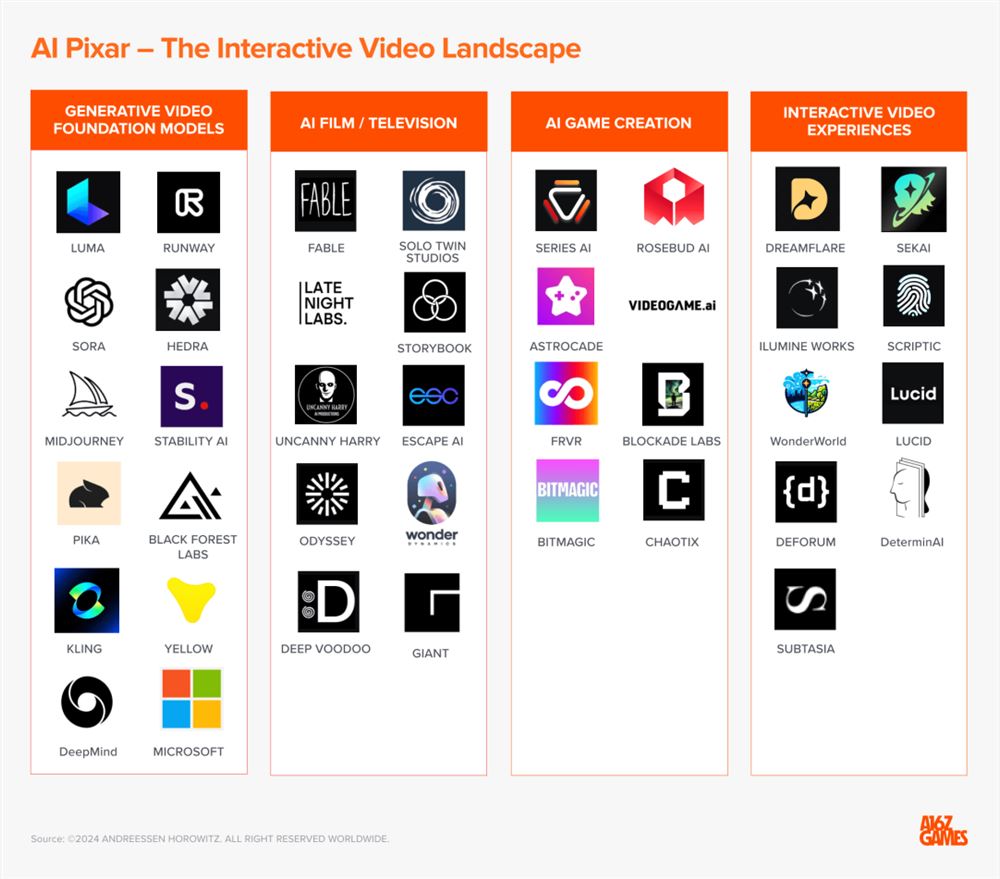

现状:互动视频格局

考虑到底层硬件和模型改进的速度,我们估计可能还需要约2年的时间才能实现商业上可行的、完全生成的交互式视频。

如今,我们看到研究方面取得了进展,微软研究院和 OpenAI 等机构正在努力为交互式视频构建端到端的基础模型。微软的模型旨在以3D 形式生成完全“可玩的世界”。OpenAI 展示了一个 Sora 演示,其中该模型能够“零样本”模拟 Minecraft,“Sora 可以同时使用基本策略控制 Minecraft 中的玩家,同时以高保真度渲染世界及其动态。”

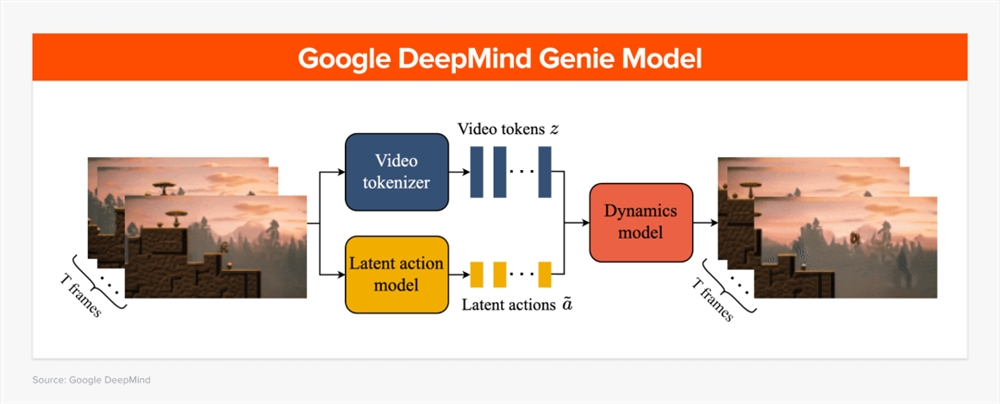

2024年2月,Google DeepMind 发布了自己的端到端交互式视频基础模型Genie。Genie 的新颖方法是其潜在动作模型,该模型可推断出一对视频帧之间的隐藏动作。通过300,000小时的平台视频训练,Genie 学会了区分角色动作 - 例如如何跳过障碍物。此潜在动作模型与视频标记器相结合,被输入到预测下一帧的动态模型中,从而拼凑出交互式视频。

在应用层,我们已经看到一些团队探索新形式的交互式视频体验。许多公司正在制作生成式电影或电视,围绕当前模型的局限性进行设计。我们还看到一些团队将视频元素融入 AI 原生游戏引擎中。

Ilumine 旗下的 Latens 正在开发一款“清醒梦模拟器”,用户在梦境中行走时可以实时生成画面。轻微的延迟有助于创造一种超现实的体验。开源社区 Deforum 的开发人员正在使用沉浸式交互式视频创建现实世界的装置。Dynamic 正在开发一款模拟引擎,用户可以使用完全生成的视频以第一人称视角控制机器人。

在电视/电影领域,Fable Studio 正在开发 Showrunner,这是一项 AI 流媒体服务,可让粉丝重新制作自己版本的热门节目。去年夏天,Fable 的概念验证 South Park AI 首次亮相,观看次数达到800万次。Solo Twin 和 Uncanny Harry 都是专注于 AI 的前沿电影制作工作室。Alterverse 构建了一款受 DD 启发的交互式视频 RPG ,由社区决定下一步的走向。Late Night Labs 是一家新的一流电影工作室,将 AI 融入创作过程。Odyssey 正在构建一个由4个生成模型驱动的视觉叙事平台。

随着电影和游戏之间的界限变得模糊,我们将看到 AI 原生游戏引擎和工具的出现,为创作者提供更多控制权。Series AI 开发了 Rho Engine,这是一个用于 AI 游戏创作的端到端平台,并正在利用其平台与主要 IP 持有者合作打造原创游戏。我们还看到 Rosebud AI、Astrocade 和 Videogame AI的 AI 创作套件使刚接触编码或艺术的人能够快速开始制作交互式体验。

这些新的人工智能创作套件将打开讲故事的市场——使新一代公民创作者能够通过结合快速工程、视觉素描和语音听写将他们的想象力变为现实。

05.

谁将打造互动式皮克斯?

皮克斯能够利用计算机和3D 图形领域的基础技术转变来打造一家标志性公司。如今,生成式人工智能领域也掀起了类似的浪潮。然而,同样重要的是要记住,皮克斯的成功很大程度上要归功于《玩具总动员》和约翰·拉塞特领导的世界级故事讲述者团队创作的原创动画电影。人类的创造力利用新技术创作出了最精彩的故事。

同样,我们认为下一个皮克斯既需要成为世界一流的互动故事工作室,也需要成为顶尖的技术公司。鉴于人工智能研究进展如此迅速,创意团队需要能够与人工智能团队携手合作,将叙事和游戏设计与技术创新融合在一起。皮克斯拥有一支独特的团队,将艺术与技术融为一体,并与迪士尼合作。今天的机会是让一支新团队将游戏、电影和人工智能学科连接在一起。

需要明确的是,这将是一个挑战——而且这不仅仅受到技术的限制——这个团队需要找到新的方式让人类讲故事的人与人工智能工具一起工作,以增强而不是削弱他们的想象力。还有许多法律和道德障碍需要解决——目前,除非创作者能够证明拥有用于训练模型的所有数据的所有权,否则人工智能生成的创意作品的合法所有权和版权保护尚不明确。训练数据背后的原创作家、艺术家和制作人的报酬仍需解决。

然而,今天同样明显的是,人们对新的互动体验有着巨大的需求。从长远来看,下一个皮克斯不仅可以创造互动故事,还可以创造整个虚拟世界。我们之前写过永无止境的游戏的潜力——动态世界将实时关卡生成与个性化叙事和智能代理相结合——类似于 HBO 的《西部世界》愿景。互动视频解决了将《西部世界》带入生活的最大挑战之一——即时创建大量个性化、高质量、互动的内容。

有一天,在人工智能的帮助下,我们可能会开始创作过程,构建一个故事世界——一个我们设想的由角色、叙事线、视觉效果等完全形成的 IP 宇宙——然后为观众或情况生成我们想要的单个媒体产品。这将是跨媒体叙事的最终演变,完全模糊传统媒体形式之间的界限。

皮克斯、迪士尼和漫威都能够创造出令人难忘的世界,成为粉丝核心身份的一部分。下一个互动皮克斯的机会是利用生成式人工智能来做同样的事情——创造新的故事世界,模糊传统讲故事格式之间的界限,并在此过程中创造出我们以前从未见过的宇宙。

更新于:3个月前