英伟达官宣AI聊天机器人,本地RTX显卡运行,这是要挑战OpenAI?

OpenAI 进军芯片领域,英伟达自己造聊天机器人,这是 Sam vs Jensen 的时代?

下载地址:https://www.nvidia.com/en-us/ai-on-rtx/chat-with-rtx-generative-ai/

在这波 AI 淘金热里,英伟达经常被称为那个「卖铲子的人」,而且卖的是难以替代的铲子。依靠这个角色,英伟达市值已经超越亚马逊,成美股第四大公司,离谷歌市值仅一步之遥。

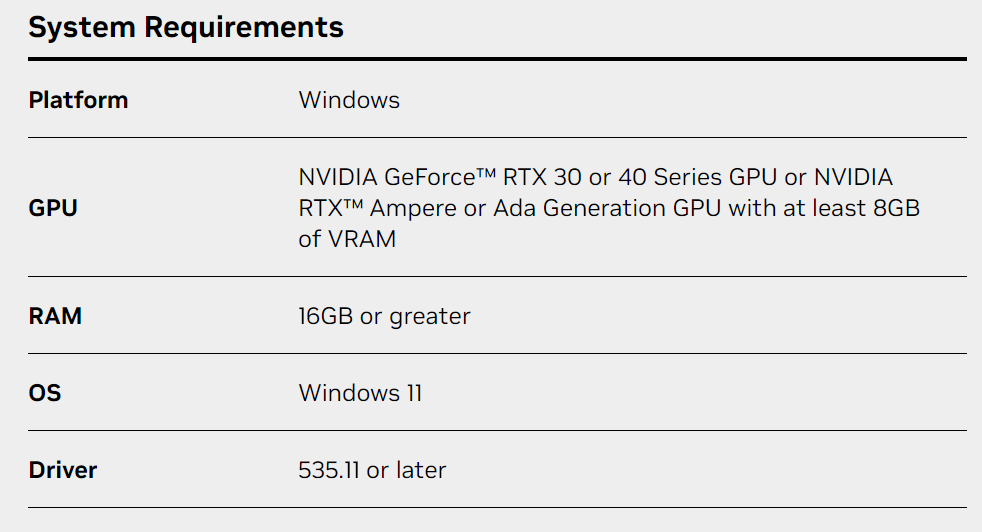

但值得注意的是,英伟达本身也在这波 AI 浪潮里淘金。刚刚,他们发布了一个对话机器人 ——「Chat with RTX」,面向 GeForce RTX30系列和40系列显卡用户(至少有8GB VRAM)。有人开玩笑说,Sam Altman 进军芯片领域,黄仁勋进入聊天机器人的领域,这是 Sam vs Jensen 的时代。

与 ChatGPT 等需要联网使用的聊天机器人不同,Chat with RTX 可以在本地运行,帮你检索、分析保存在电脑上的文件(支持文本、PDF、.doc、.docx 和 .xml 等格式)。比如,你可以问它「在拉斯维加斯时,我的搭档推荐了哪家餐厅?」Chat with RTX 将扫描你指向的本地文件,并提供带有上下文的答案。

此外,它还可以帮你分析、总结 Youtube 上的视频,而且只需要你提供网址。科技媒体 The Verge 资深编辑 Tom Warren 在试用之后表示,Chat with RTX 在视频中找参考资料的速度非常快,只需要几秒就能给答案,不过有时也会出错,找到驴唇不对马嘴的视频文字记录。

据悉,Chat with RTX 默认使用人工智能初创公司 Mistral 的开源模型,但也支持其他基于文本的模型,包括 Meta 的 Llama2。它会利用 RTX GPU 上的 Nvidia Tensor core 来加快查询速度。Nvidia 警告说,下载所有必要文件会占用相当大的存储空间 ——50GB 到100GB,具体取决于所选模型。

Tom Warren 表示,他的电脑采用英特尔酷睿 i9-14900K 处理器,配备 RTX4090GPU,安装 Chat with RTX 大约花了30分钟。在他系统可用的64GB 内存中,Python 实例占用了大约3GB 内存。程序运行后,他可以通过浏览器访问 Chat with RTX,而后台运行的命令提示符会显示正在处理的内容和任何错误代码。

Tom Warren 还发现,Chat with RTX 在扫描 PDF 文件和核对数据时非常有用。微软自己的 聊天机器人系统在 Word 中不能很好地处理 PDF 文件,但 Chat with RTX 聊天系统可以毫无问题地提取出所有关键信息,回复也近乎即时,没有通常使用基于云的 ChatGPT 或聊天机器人时的延迟。

不过,作为一款早期产品,Chat with RTX 还有很多不完善的地方。

一个比较大的缺点是,它不能记忆上下文。比如,你问「北美常见的鸟类是什么?」,然后接着问「它是什么颜色?」,它就不知道你是在问鸟的颜色。

英伟达还承认,Chat with RTX 回复的相关性会受到一系列因素的影响,其中有些因素比较容易控制,包括问题的措辞、所选模型的性能和微调数据集的大小。询问几份文档中涉及的事实可能比询问一份文档或一组文档的摘要得到更好的结果。英伟达表示,随着数据集的增大,响应质量通常也会提高,将 Chat with RTX 指向有关特定主题的更多内容也是如此。

所以,整体来看,Chat with RTX 还是一个初级的产品,暂时不太适合用于生产。但它代表了一种趋势,即让 AI 模型更容易地在本地运行。

世界经济论坛在最近的一份报告中预测,能够离线运行生成式 AI 模型的经济型设备将「大幅」增长,其中包括个人电脑、智能手机、物联网设备和网络设备。报告表示,原因在于其明显的优势:离线模型不仅在本质上更加私密 —— 它们处理的数据永远不会离开运行的设备,而且与云托管模型相比,它们的延迟更低,成本效益更高。

英伟达公司创始人兼首席执行官黄仁勋表示:「生成式人工智能是计算史上最重要的一次平台转型,它将改变包括游戏在内的每一个行业。英伟达拥有超过1亿台 RTX AI PC 和工作站,是开发者和游戏玩家享受生成式人工智能魔力的庞大安装基础。」

Chat with RTX 技术 demo 由 GitHub 上的 TensorRT-LLM RAG 开发人员参考项目构建而成。开发人员可以使用该参考项目为 RTX 开发和部署自己的基于 RAG 的应用程序,并通过 TensorRT-LLM 进行加速。

项目地址:https://github.com/NVIDIA/trt-llm-rag-windows

更新于:10个月前