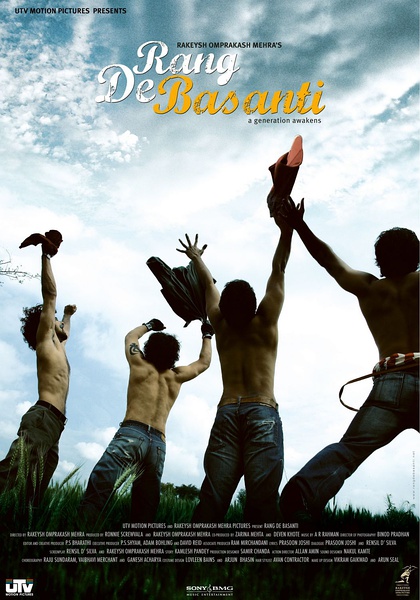

【电影】《芭萨提的颜色》

2024-09-29 09:00

影片中的英国女电影人苏,乃由末任香港总督彭定康幼女彭雅思饰演。 ***过印度***者的英国警官被***者视死如归的气概所感动,留下了一本记录当时情况的日记。多年后,他的孙女Sue(彭雅思 Alice Patten 饰)阅读日记后深受感动,凭着一腔热血辞掉电影公司的工作,来到印度拍摄这部记录那段历史的影片。Sue到德里大学的学生中选角。一群充满朝气却和芸芸大众一样对印度这个国家心如死灰的年轻人以及进入她的

- 原名:Rang.De.Basanti

- 地区:印度

- 语 言:乌尔都语

- 首播:2006-01-26 周四

- 制作公司:

- 类型:动作/剧情/喜剧/历史

- 翻译:暂无

- IMDB:8.1分/117279人评tt0405508

- 别名:染上黄色 / 青春无敌

- 导演:拉凯什·奥姆普拉卡西·梅赫拉

- 編劇:伦齐尔·达席尔瓦 / 普拉松·乔希 / 拉凯什·奥姆普拉卡西·梅赫拉 / 卡姆利什·潘迪

- 主演:阿米尔·汗 / 悉塔尔特 / 沙尔曼·乔希 / 库纳尔·卡普尔 / 阿图尔·库尔卡尼 / 彭雅思 / 苏哈·阿里·汗 / 斯蒂文·麦金托什 / 马达范 / 瓦希达·拉赫曼 / 阿努潘·凯尔 / 凯伦·凯尔 / 欧姆·普瑞 / 詹丹·罗伊·萨纳尔

相关影视