阿里可控视频生成框架DreaMoving开源

2023-12-21 14:13

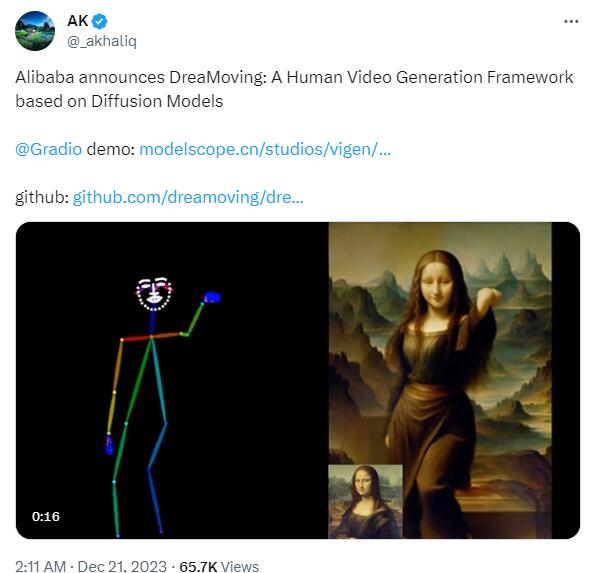

今天,阿里可控视频生成框架DreaMoving正式开源,从网友测试的效果来看,其对人物运动的控制还是比较理想的。

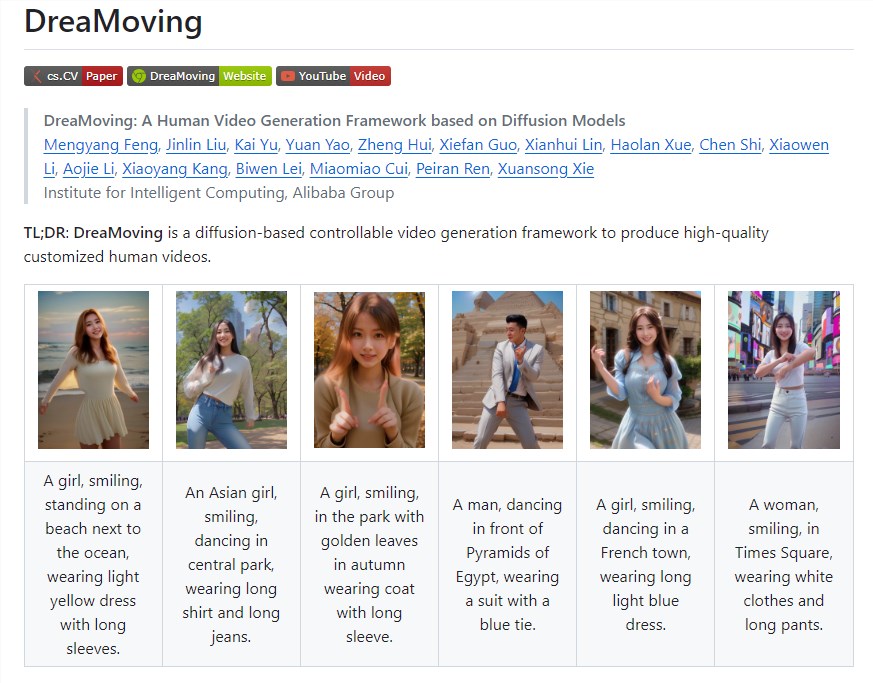

据介绍,DreaMoving是基于扩散模型的可控视频生成框架,用于产生高质量定制的人类视频。DreaMoving允许用户生成具有高度自定义特征的人类视频,如在沙滩上微笑的女孩,中央公园跳舞的亚洲女孩等。

代码:https://github.com/dreamoving/dreamoving-project

试玩地址:https://www.modelscope.cn/studios/vigen/video_generation/summary

DreaMoving是一种可以生成高质量和高保真度视频的技术,它能够根据给定的指导序列和简单的内容描述,例如文本和参考图像作为输入,生成视频。

具体来说,DreaMoving通过人脸参考图像、通过姿势序列进行精确运动操作以及由指定文本提示提示的综合视频外观控制来展示身份控制的熟练程度。这意味着,只需要“投喂”一张人像和一段提示,就能够生成对应的视频,而且改变提示,人物背景和身上的衣服也会跟着变化。

为了实现这一目标,DreaMoving技术引入了两个关键组件:Video ControlNet和Content Guider。其中,Video ControlNet是一个图像ControlNet,通过在每个U-Net块后注入运动块,处理控制序列(姿势或深度)以产生额外的时间残差,从而有效实现了对运动的控制。而Content Guider组件则负责将输入文本提示和外观表达(如人脸,衣物是可选的)转换为内容嵌入,实现跨注意力的传递。

更新于:2023-12-21 14:13

分享