多模态音乐AI框架Video2Music 为视频生成情感相符的音乐

近日,一款创新的人工智能多模态音乐生成框架Video2Music引起了广泛关注。该框架利用独特的数据集和经过用户研究验证的转换器模型,能够为视频生成情感上相符的音乐,填补了这一领域的空白。据悉,Video2Music的GitHub Repo已经发布,为研究人员和音乐爱好者提供了一个全新的工具。

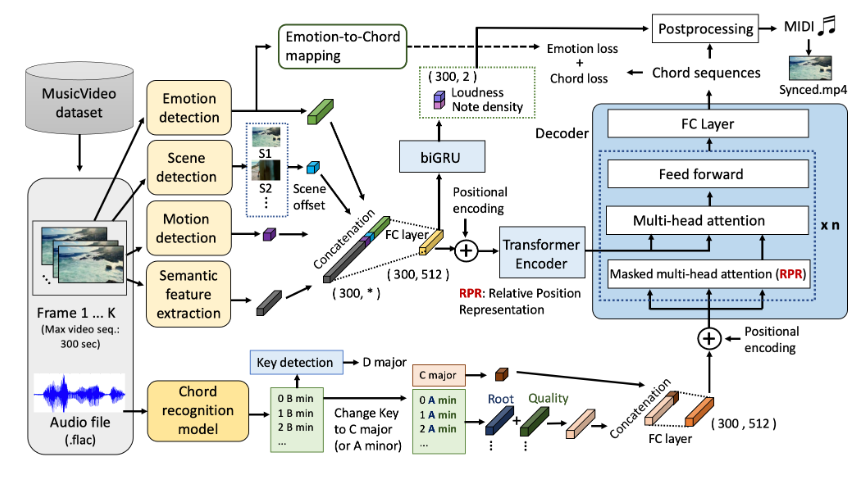

Video2Music的AI框架是一项非常有前景的技术,它能够根据视频内容自动生成情感相符的音乐。它采用了一种前沿的 Transformer 模型,以视频特征作为输入条件,生成与视频匹配的音乐。这一框架的目标是为视频创作者提供一种无缝高效的解决方案,用于生成定制的背景音乐。

项目地址:https://github.com/amaai-lab/video2music

这一框架的独特之处在于它利用了经过用户研究验证的转换器模型,确保了生成音乐与视频情感的贴合度。通过对独特的数据集进行训练,该框架可以准确捕捉视频中的情感变化,并将其转化为音乐的情感表达。

Video2Music的出现为视频和音乐的结合提供了新的思路,为用户创造了更加个性化和情感丰富的体验。期待这一技术能够在未来得到更广泛的应用,为音乐和视频领域带来更多的可能性。

核心功能:

利用 Transformer 架构生成音乐:Video2Music 以视频特征作为输入,使用 Affective Multimodal Transformer(AMT)模型生成音乐。这意味着生成的音乐将与视频内容相匹配,为视频创作者提供更好的音乐配乐选项。

高级音乐生成技术:Video2Music 使用先进的技术,包括 Bi-GRU 回归模型,用于预测音符密度和音量,以确保生成的音乐在音质和音量方面达到最佳效果。

数据集支持:该产品附带了 MuVi-Sync 数据集,包括视频特征、原始视频和原始音频,以支持模型训练和生成。这使用户可以轻松访问用于生成音乐的必要数据。

模型训练和推理:Video2Music 提供了用于模型训练和推理的脚本,用户可以根据自己的需求自定义训练和生成过程,以获得最佳的音乐生成结果。

引用支持:如果用户认为这一资源对其有用,可以轻松引用原始工作,使研究和创作更具可信度。这有助于学术和创作领域的知识传播。

更新于:2023-11-08 12:36