NASA正式宣布:将送阿汤哥上太空拍电影!

2024-08-22 20:24

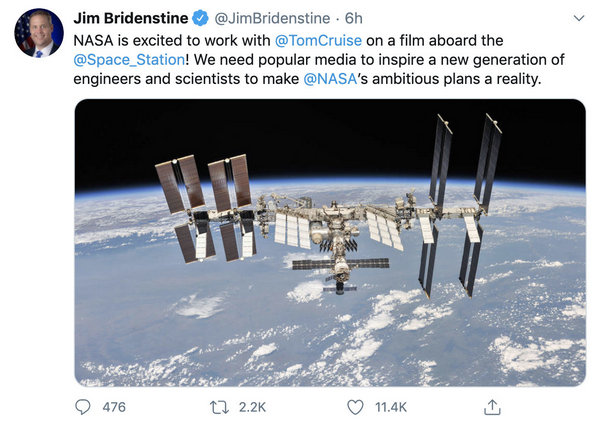

昨日,据Deadline独家报道,汤姆·克鲁斯与埃隆·马斯克的SpaceX公司一起,正在与NASA商谈打造一部在外太空拍摄的动作电影。美国航天局局长今日在社交媒体上宣布,NASA将与汤姆·克鲁斯一同在太空站拍电影,“我们需要大众媒体来激励新一代工程师和科学家将NASA雄心勃勃的计划变成现实。” 埃隆·马斯克在此条消息下留言:“这会很有趣的!”二人的互动证实此前Deadline的报道。

据悉,此项目不是《碟中谍》系列,目前尚在早期商谈中,尚无电影公司介入。此消息一出,全球网友惊呼,阿汤哥继爬迪拜塔、扒飞机后,终于要冲出地球啦。果然地球已经不能满足汤姆·克鲁斯拍动作片了。

2018年10月份,《碟中谍6:全面瓦解》的导演克里斯托弗·迈考利在接受外国媒体采访时提到,《碟中谍》系列将有一天会跑到外太空拍电影,这只是时间问题。而登上太空的演员会是阿汤哥,或者是《阿凡达》的导演卡梅隆、还可能是《星际穿越》的导演克里斯托弗·诺兰。当时此消息出来时,被媒体和影迷们认为是很大胆的想法。然而两年不到的时间,此想法就真的被提上日程,只是具体电影不是《碟中谍》系列。

演员登上外太空,甚至在外太空拍电影简直是很多人不敢想象的。阿汤哥在拍片方面是个“拼命三郎”,尤其是在《碟中谍》系列电影中,阿汤哥贡献了一系列令人瞠目结舌的动作戏。相信此次在太空拍摄电影的想法真实落地的话,阿汤哥一定是跃跃欲试的。

相关资讯

郑大圣《一号密档》正式开机 还原党史真实事件

近日,由郑大圣执导的电影《一号密档》(密档)在上海正式开机。影片由张琪、贺子壮担任编剧,袁弘等人出演,取材自有关中央文库的真实历史事件。影片讲述了在日伪时期,绝密的中共文件藏匿于一幢人蛇混杂的居民楼中。在腥风血雨的环境中,文档保管员突破敌伪围剿,在完成延安高难..

《美国队长4》发布正式预告 美队大战红浩克

《美国队长4》新浪娱乐讯 北京时间12月26日消息,据外国媒体报道,漫威新片《美国队长4》发布正式预告。安东尼·麦凯饰演的“猎鹰”萨姆·威尔逊接任美国队长,大战美国总统变身的红浩克,面对阴谋和危机。“一场战争将来临,谁也不能信任”。该片名为《美国队长:勇敢新世界》。..

诺兰新作正式定名为《奥德赛》,马特·达蒙、汤姆·霍兰德参演

新京报讯(记者周慧晓婉)12月24日,据外媒报道,环球影业正式宣布克里斯托弗·诺兰执导的神话动作史诗片定名为《奥德赛》(The Odyssey)。影片改编荷马史诗的同名故事:特洛伊战争后,奥德修斯回乡的漫长旅程。目前该片北美定档2026年7月17日。阵容方面,马特·达蒙、汤姆·霍兰德..

皇冠3子正式摊牌,打响反击第一枪!琼瑶最担心的事还是发生了

琼瑶自杀离世,文学界又少了一位大佬。不愿受病痛折磨的她,早早就安排好了一切,翩然离去,不带走一丝一毫。她生前积累的财富,引得很多人觊觎。虽然说有个睿智的儿媳妇给撑着,可是身怀宝藏,怎么可能少了惦记的人呢?在琼瑶葬礼结束后,关于这场巨额财富的战争才正式拉开了帷幕..

《孤星计划》正式上映 王源唱响青年勇敢报国心

日前,谍战悬疑电影《孤星计划》在全国正式公映,并发布由王源献唱的主题曲《别丢了你的勇敢》MV和孤勇少年版海报。电影讲述百年前一群临危受命的青年为完成一场绝密护送任务,与各方势力展开斗智斗勇的生死搏杀。影片由黄建新监制,任宁担任制片人,徐展雄执导,张冀担任剧本监制..

傀儡们纷纷倒下,乱纪元正式开篇

一些地方该变天了,也许到了该出手的时候。风大浪高,点击卡片,关注防迷路韩国男性,果然又短又快。被各路公知吹的天花乱坠的首尔之春电影,总时长2小时21分钟。尹锡悦搞的草台班子政变,总时长2小时15分钟。电影还没出职员表,戒严令就成了厕纸。整个政变过程充满着不可言状的喜..

拍电影质感的电视剧,《上甘岭》主创分享了这些经验

“收视冠军”“电影质感”“缅怀先烈”“感动满满”,这几个关键词指向了今年大爆的电视剧《上甘岭》。自10月14日开播以来,《上甘岭》收获了无数好评,收视率持续领跑,屡创新高,位列总局中国视听大数据CVB历史收视之冠。在索福瑞全国网的收视数据中,该剧全剧平均收视1.24%,平..

《燃霜为昼》正式杀青 王玉雯田嘉瑞演绎乱世情仇

11月29日,由优酷出品,阿里影业、吉时羽(上海)文化有限公司联合出品,拾穗工作室打造,刘畅执导,张文丽担任总制片人,慕妤担任制片人的民国情感大戏《燃霜为昼》在经历了紧张的拍摄后,正式官宣杀青。该剧由王玉雯、田嘉瑞领衔主演,李汶翰特别主演、孔雪儿特邀主演、饶嘉迪、..

每体:博格巴哥哥的绑架与敲诈案已正式开庭审理

据《每日体育报》报道,围绕保罗-博格巴的“绑架与敲诈案”在巴黎刑事法院正式开庭审理。案件涉及保罗的哥哥马蒂亚斯-博格巴及其五名童年好友,他们被控企图敲诈和绑架保罗,并索要1300万欧元。庭审预计持续至12月3日。案件源于2022年,时任尤文图斯球员的保罗-博格巴曾向警方举报..

南充这部剧优酷正式上线!

11月25日,由四川金屏韶光影视传媒有限责任公司出品、南充首部实名实景拍摄的剧集《在世界中心遇见你》在优酷网络平台正式上线播出。《在世界中心遇见你》是一部以南充为背景,并在南充全景拍摄的16集励志爱情喜剧题材网络剧。整部剧主要讲述了发生在南充的一段曲折动人的故事,展..

《碟中谍8》预告震撼出炉,阿汤哥赤膊上阵

《碟中谍8:最终清算》(Mission: Impossible - The Final Reckoning)首款预告劲爆出炉,阿汤哥继续各种卖命,看过之后的小编不得不佩服。在这份动作戏十足的预告中,大家会看到汤姆·克鲁斯(Tom Cruise)潜水并探索一艘失事的潜艇,在一家双翼飞机上铤而走险,当然还有各种不顾..

性感女神剧里剧外都当了妈!《权力的游戏》又要拍电影?

根据《好莱坞报道》,华纳兄弟被曝正在悄悄开发至少一部《权力的游戏》(Game of Thrones)大电影。根据知情人士透露,这一项目还处于非常早期的阶段,目前还没有敲定电影人、演员或者编剧,但华纳对把维斯特洛大陆搬上大银幕的想法充满热情。此前,剧版的剧集运作人戴维·贝尼奥..

报道称《质量效应》电视剧已正式进入制作阶段

几年前报道过的根据《质量效应》改编的电视剧现在“正式制作中”。据《综艺》杂志最新报道,亚马逊米高梅影业公司最终将继续推进该项目。 该剧将由丹尼尔·凯西(第九部《速度与激情》的编剧)担任编剧和执行制片人,卡里姆·茨雷克(《杰西卡-琼斯》)和阿里·阿拉德(《蜘蛛侠..

《乡村爱情18》正式开机,原班人马现身,网上骂声一片、吐槽不断

《乡村爱情18》正式开机了,如果是之前,肯定很多人都十分期待这部剧,但现在网友们对这个消息可谓是骂声一片。就算主创团队全都现身,也没办法逆转这部剧的口碑。那么,《乡村爱情》是怎么一步步走到这样的地步的?《乡村爱情》口碑下降《乡村爱情》这部情景喜剧已经陪伴我们走过..

黄子华、许冠文矛盾爆发!《破·地狱》曝正式预告

近日,由黄子华、许冠文主演的电影《破地狱》发布正式预告片。预告片中,道生与文哥、生者与死者、现代与传统、父亲与女儿之间的种种矛盾逐渐显现,结尾道生一句活人也是要破地狱的带来无尽猜想。电影是香港首部以殡仪业为题材的影片,这也是黄子华与许冠文两代笑匠继1992年《神..

师徒情断!刀郎公司发布声明,14年两人就已正式分道扬镳

声明:本文内容均是根据权威资料,结合个人观点撰写的原创内容,文中标注文献来源及截图,请知悉。前言娱乐圈就像一个大舞台,名和利在这里无处不在,人与人之间的情感变化和世态炎凉也被放大了很多倍。曾经亲密无间的合作伙伴,可能转眼间就形同陌路;曾经被奉为佳话的师徒情谊,..

《奔跑吧:茶马古道篇》正式开跑,杨颖继续缺席,全新一季更精彩

作为国内最火爆的真人秀综艺,已经有过十个年头的《奔跑吧》,可以说是给我们留下了太多回忆!特别是在两季中间新增了特别季后,更是让我的感受到了更多的人文情怀!这就比如此前的《黄河篇》《生态篇》,都赢得了观众的喜爱和认可!也正是在这样的情况下,当新的《奔跑吧》特别季..

《直到黎明》改编电影现已杀青!预计明年正式上映

由知名恐怖冒险游戏《直到黎明》改编的电影今日官宣杀青,影片预计将于明年上映。该影片讲述八个朋友、死敌在偏远的山间度假胜地重聚,原本愉快的聚会却因接连不断的神秘事件而演变为生死危机。影片中,八位主角将面临神秘杀手的追击、食人魔的威胁以及矿洞塌方等重重危机,他们必..

陆川拍电影就像鱼,他自己只能记得七秒钟剧情

今日国产电影之无聊程度,大概就是,一般的烂片都不值得大家问一句“到底能烂成什么样啊”。(老朋友们大概也注意到这几年“我为人民看烂片”的更新频率其实是大大降低了!因为烂不出花!)从这个意义上说,陆川还是刷到了存在感的,他能把《749局》拉回过去那种——“看,这里有..

电影《捉刀人》正式上映 释小龙乱世捉刀匡扶正义

近日,动作武侠电影《捉刀人》于爱奇艺云影院正式上映。影片由魏君子担任总制片人、秦鹏飞导演,释小龙领衔主演,屈菁菁特别出演,唐文龙、淳于珊珊主演,讲述了与成瞎子齐名的捉刀人豺狗裴兴(释小龙 饰),见证坚持心中公义的好友被强权抹杀后心中的侠义因此逐渐被唤醒,于是决..

一票难求、超10亿讨论…这个国民爆款拍电影了!

国庆档正式开启预售,而电影《只此青绿》早在9月初就开启点映。影片改编自同名舞蹈诗剧,讲述了一位现代文物研究员(谢素豪 饰)在《千里江山图》即将展出之际潜心钻研,跨越九百余年时空走入北宋少年画家希孟(张翰 饰)的内心,将少年希孟和《千里江山图》背后的故事娓娓道来。..

朴有天在日本正式发行新专辑 以歌手身份solo出道

9月23日,据韩媒报道,朴有天将于12月18日在日本发行新专辑。据悉,9月20日,朴有天刚在东京举行了出道迷你专及圣诞巡演的记者会,将首次以solo歌手的身份正式发行专辑。

央八正式开播!38集反特谍战剧来了!王志文领衔13位老戏骨,要火

在某个节目中,王劲松曾公开夸赞王志文,说他最喜欢王志文演的戏。因为他演得戏,“是可以只用耳朵听的”。确实,王志文的台词功力,几乎无懈可击。哪怕闭上眼睛只用听,也能感受到人物角色的精明,与角色的情绪来,张弛有度、口齿清晰。那么,58岁的王志文,与57岁的王劲松,来一..

阿汤哥被曝无偿出演巴黎奥运闭幕式 拒绝用替身要求亲自上阵

在最近一次采访中,担任下届洛杉矶奥运会主席凯西·沃瑟曼谈到了汤姆·克鲁斯在巴黎奥运会闭幕式上的表现,称赞他非常专业,并且自愿参与演出并且没有收取任何费用。沃瑟曼表示:“我确信再也找不到像他这样的人,他无疑是更好的合作伙伴。”..

《周六夜时光》曝正式预告 聚焦SNL传奇诞生之夜

近日,电影《周六夜时光》公布正式预告。本片聚焦1975年10月11日晚上,经典小品综艺节目《周六夜现场》(简称SNL)首集播出前九十分钟所发生的幕后故事。在经历种种幽默、混乱和神奇的事情后,SNL即将诞生。在预告中,由加布拉贝尔饰演的SNL创始人兼总导演洛恩迈克尔斯正在拼命保..

玄彬谈孙艺珍对自己拍电影的帮助:仅是存在我就非常感谢了

9月9日,玄彬出席电影《哈尔滨》在多伦多电影节的首映礼。受访时,被问到孙艺珍为他拍摄电影给予了什么帮助?他回答:“她很理解我,能理解本身就很重要了,所以她仅是存在我就非常感谢了,我的所有一切她都给予了支持。”..

《欲望都市》续集即将开播!正式预告发布!

很多资深美剧迷期盼已久的《欲望都市》续集新剧《就这样…》正式预告发布!凯莉、米兰达、夏洛特三位主角回归,新造型也在预告片中曝光。大人物、艾登、斯坦福·布拉奇等也确认回归!虽然“萨曼莎”金·凯特罗尔不会回归本剧略显遗憾,但是看到如今仍旧风采依旧的回归的主角们,也..

神盾局局长+猎鹰主演电影《银行家》内地正式定档!

“奇招创业,逆流改命” ——为了梦想,你需要付出多大代价?本片由“神盾局局长”塞缪尔·杰克逊携手“猎鹰”安东尼·麦凯外加尼古拉斯·霍尔特共同主演。George Nolfi(《龙之诞生》《命运规划局》)执导。该片改编自真实事件,讲述1950年代的美国,两个黑人企业家想法子打破种族..

传承民族精神谱写英雄史诗《归队》正式开机

中新网北京9月2日电 (记者 高凯)9月2日,由国家广播电视总局重点指导,为纪念抗日战争胜利80周年而创作的精品大剧《归队》正式开机。 《归队》由腾讯视频出品,无止境文化联合出品并承制,北京市广播电视局、中共黑龙江省委宣传部、中共吉林省委宣传部、中共辽宁省委宣传部联合出..

《007:无暇赴死》即将全球首映,大陆正式定档!

《007:无暇赴死》9月30日英国上映,10月8日北美上映,中国内地正式定档10月29日!《007:无暇赴死》据说是克雷格最后一次出演邦德,电影中,世界局势波诡云谲,再度出山的邦德面临有史以来空前的危机,传奇特工007的故事在本片中达到高潮。新老角色集结亮相,蕾雅·赛杜回归,二..