Llama2开源后,国产大模型在卷什么?

「GPT 还是 Llama2?」过去几周时间里,许多大模型应用层的开发者不得不开始集中思考这个问题。

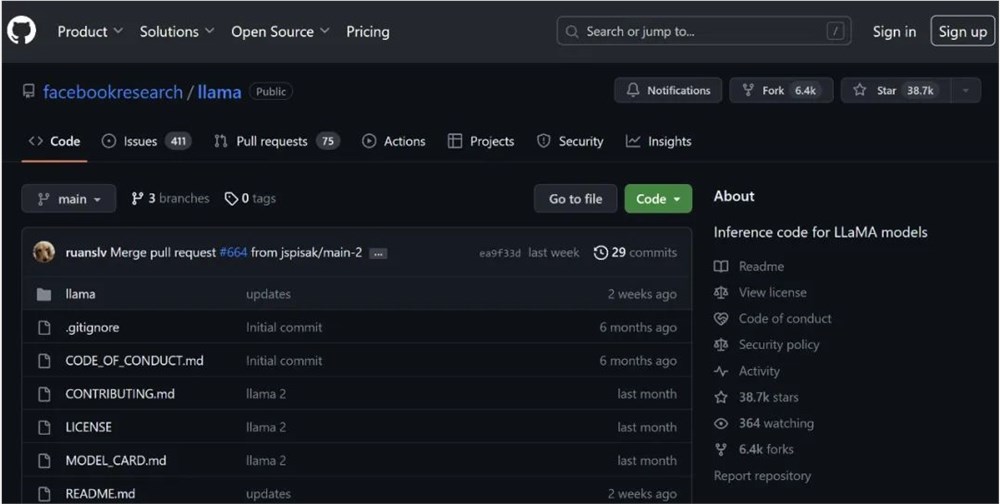

7月19日,开源社区最强的大模型从 Llama 升级到 Llama2。后者在2万亿的 token 上进行训练,训练数据增加了40%,在包括推理、编码、精通性和知识测试等许多外部基准测试中,皆优于其他开源语言模型。

「以前的开源大模型都没有形成像 Llama 这样的社区,而 Llama 系列模型正是在这种非常活跃的社区文化下发展起来了,这也直接造成 Llama 系列模型在很多任务上都取得了快速进展,甚至达到了商用标准」,东北大学教授肖桐向机器之心解释。

GPT-3.5水平通常被认为是大模型商用的标准线,在 Llama2模型70亿、130亿和700亿三种参数变体中,700亿的版本在 MMLU 和 GSM8K 上接近了 GPT-3.5的水平。这意味着,作为开源大模型的代表,Llama2第一次进入了大范围的商业考量决策之中,开发者们拥有了一个免费、开源且足够商用的大模型底座。

今年5月份,谷歌一位工程师在内部撰文直言称,当免费的、不受限制的替代品(开源模型)与闭源模型质量相当时,人们不会为受限制的模型付费。

两个月以后,这一预测变成现实。用 Llama2进行模型训练的开发者数量正在快速增加。根据Meta披露的信息,Llama2在发布的一周内就接收到了超过15万次的下载请求,并且仍在持续增加,Meta 对此表示「不敢置信」。

开源与闭源大模型的比赛从此刻开始正式打响。面对开源大模型更低的成本、更快的迭代速度、更高的定制化上限,闭源大模型的壁垒会由什么构建,成为一个问题。

Llama2还是 GPT-4

选择 Llama2的原因有很多,成本是最直接的一个。

当前,GPT-4接口的调用费用为每1000个提示请求 token 花费0.03美元,完成响应 token 花费0.06美元。斯坦福大学研究员在一份论文中估算,如果是中小企业利用 GPT-4来协助市场工作的话,每个月的成本可能超过2.1万美元。而一个利用 GPT-4辅助广告文案生成的公司则表示,它们平均每个月要为 GPT-4接口支付超过25万美元的成本。

一家国内 AIGC 应用商对机器之心透露,Llama2虽然目前在技术水平上距离 GPT-4有一定差距,但是相比于 GPT-4的高昂成本,团队仍然选择了使用 Llama2作为底层模型,通过在产业中积累的行业数据以及专注在垂直场景进行输出,能够弥补一部分技术代差。

「Llama2出现之后,受打击最大的应该就是 OpenAI,更多的公司会开始直接基于 Llama2进行商业化开发,而不再购买它们的 API。」猎豹移动董事长兼CEO傅盛称。

在免费的冲击下,原先使用 OpenAI 接口的应用层公司会重新思考应该选择哪个路线,有一部分的市场或许将会被 Llama2重新洗牌。

不过,这个决策并不完全是成本之上的较量。对于「较好的数据和优化是否能够弥补如今 Llama2与 GPT-4差距」这个问题,消极的声音占据较多数。

东北大学教授肖桐举例称,以机器翻译场景为例,我们可以用一个类似于 Llama2这样的开源模型去做指令微调,虽然翻译性能达到不错的程度,但是最终会发现性能上限仍然受限,因为开源大模型的某些能力是在预训练阶段获得的,所以即使你的指令、任务都是明确的,加上很多数据,但你会发现仍然不容易做到 GPT-4的效果。

另外,相比于往常的披露,此次 Llama2开源并没有对外披露数据层的具体信息,因此复现 Llama2成为一件受限制的事情。「比如一座楼房,你只能在这个基础之上去装修却做外设,但是你没有办法去改变它的钢混结构,你没有训练它底座的权限和能力,所以它的性能很难突破,逼近 GPT-4这个事情是不可能的」,昆仑万维 CEO 方汉认为。

一些应用开发者则认为,按照此时 Llama2与 GPT-4的水平差距,如果全力押注 Llama2,付出的代价可能同样很大。「可能你要花很多时间在优化 Prompt 上,而不是产品创新。」

因此,在技术的绝对领先下,GPT-4仍然会持续吸引到对效果有相对极致的、在成本方面有较大空间的客户。

当然,比起存量市场的转移,Llama2的更大贡献应该是对整个 AIGC 行业增量市场的拉动。一位 AIGC 业内人士向机器之心表示,Llama2的开源点燃了很多应用开发者的热情,在开源后的几周时间,许多开发者将它看成是移动互联网黄金时期的阶段,希望能找到应用的切口。

正如肖桐所言,Llama2能够支持企业和团队在大模型应用层面低成本、快速地启动,作出产品和商业模式的原形。

而随着围绕 Llama 的应用尝试越来越多,「围绕 Llama2的生态的可能会被建立起来,这种迁移是比较难的,因此生态会成为一个飞轮」,傅盛提到,之后或许将迎来一个模型平民化的阶段,使用大模型做应用的门槛将不断降低。昆仑万维 CEO 方汉则具体指出,在国内,Llama2对市场的影响将集中在小 B 市场,文生图、智能写小说这类场景会迎来更多竞争对手。

在过去的几周时间里,Llama2已被接入 Amazon Sagemaker、Databricks、Watsonx.ai、Microsoft Azure、阿里云和百度千帆等各种平台,围绕 Llama2的生态已经开始发展。

大模型创业公司的危机

对大部分底层大模型创业公司来说,一条比较明确的商业化路径是效仿 OpenAI,通过自研大约 GPT-3.5水平的模型,然后向客户提供 MaaS 服务,出售底层模型的能力。

在 Llama2推出之前,开源社区最强的大模型 Llama 在商用许可上具有限制,而 OpenAI 的接口在国内面临着不确定的监管风险,因此相比于两者,国产大模型在市场竞争中的优势通常是「可商用」、「数据安全」以及更好的「服务支持」。

Llama2的释出削弱了国产大模型创业公司在市场上的竞争力。「从许多公开的测试集上,我们可以看到,国内大部分的大模型公司的水平距离 GPT-3.5仍然有距离」,一位 AI 方向资深投资人称。也就是说,对于国内的大部分大模型创业公司来说,Llama2意味着一个价格碾压(免费)、技术更强以及可以支持商用的竞争对手。

对那些自研大模型积累不够的公司来说,Llama2产生的打击则更甚。傅盛认为,「Llama2将开源的水平提升到了接近 GPT-3.5的水平。如果说此时你的自研水平远远不如 Llama2,那么意味着可能你之前的工作都白做了。」

对这部分公司来说,当前面临两种选择,一是抛弃自研路线,利用自己此前积累的数据和经验开始用 Llama2进行开源模型训练,二是继续坚持自研路线,但是需要衡量所付出的时间和金钱成本,以及最终自身能否追赶并超越上快速迭代的开源生态。无论哪种,都是一个艰难的选择。

Llama2为开源社区贡献的新的技术里程碑,不仅拉高了闭源公司整体的自研门槛,或许还将动摇很大一部分公司「继续自研」的决心。

「对于很多公司来说,当你自研的大模型没有办法去超过 Llama2后,你会越来越没有动力去自研模型,会更倾向于站在巨人的肩膀上,这更多是一种心理层面的影响」,面壁智能 CTO 曾国洋说道。

而如果认为自己短期内凭借自研能力无法超过 Llama2的这部分公司,「很有可能就会去考虑成为端到端的应用公司,利用自己的既有模型结合开源模型,直接向市场提供应用,最后实现数据上的闭环,从而不断迭代」,上述投资人表示。

不过,对于头部大模型公司来说,「自研」路线上的摇摆现象概率要低得多。昆仑万维从2020年开始筹备大模型,已经对外推出了成熟可商用的大模型产品。昆仑万维 CEO 方汉告诉机器之心,目前对于昆仑万维而言,在技术上更值得期待的是,如何从 GPT-3.5提升到 GPT-4。「国内已经在牌桌上的大模型公司对如何做到 GPT-3.5大多已经没有什么疑问,但下一步如何做到 GPT-4仍然需要花大力气探索,因此 Llama2在技术上对大厂没有什么参考意义」。

同样已经推出成熟大模型产品的公司面壁智能CTO曾国洋持类似观点。他认为,在技术上 Llama2最多在一些具体任务上可以起到一些 Benchmark 的作用,但是 Llama2最值得参考的数据处理层面没有开源,因此整体在技术上参考意义有限。

从市场竞争的角度来看,在国内市场,相比于 Llama2,国内头部大模型公司拥有更优越的中文表现、更稳定的监管预期、更便利的服务支持以及更近的市场渠道。因此,面对于 Llama2的免费优势,能够做到在性能上更好、模型更加易用的头部大模型公司,理论上就能够继续维持整体优势。

并且,对于头部大模型公司来说,在自研路线上投入的沉没成本远远超过中尾部大模型公司,不同自研的路线往往也代表了公司的行业、场景上的侧重点,头部公司有足够的资金、人才以及驱动力继续自研。

Llama2对国内大模型公司的影响将是一个持续的过程。如今全球范围内 AIGC 行业仍在起步上升阶段,并没有稳定的市场格局。由于底层技术水平仍在早期,中国市场则更加分散,尚未发展起来。全球来看 GPT 的市场份额应当是最大的,而国内目前 Llama2能够受影响的市场仅仅只是担心 GPT 受监管影响、且国产大模型都不适用的这部分客户,是一个「暂存市场」。

不过,虽然「暂存市场」整体并不大,但在暂存市场中证明自己的模型商业化能力已经成为许多大模型公司的「融资通行证」。上述投资人告诉机器之心,在比较标的的过程中,虽然 Llama2在技术上起到的参考价值不大(有GPT-3.5),但是公司如何应对 Llama2带来的商业化危机会成为资方较为在意的点。如果说,在这场市场竞争中失败,融不到资,可能就会影响到大模型创业公司的存续问题,在目前的阶段,这可能是一个更致命的问题。

没有长期护城河

无论是 Llama2瓜分闭源公司的既有市场份额,还是推动整个行业进一步繁荣,「开源 AI 正在取得胜利」这个判断似乎拥有了更多实证。

这个观点来自于今年5月谷歌一位工程师在内网发布的文件。在谷歌与 OpenAI 仍在焦灼 AI 军备竞赛之际,这位工程师在文件中直言:开源派与谷歌和 OpenAI 模型之间的差距正在以惊人的速度缩小,它们将很快对谷歌和 OpenAI 进行超越,我们没有护城河。

「一家公司不断在前面推天花板,后面的人不停追赶,虽然它可能会有自己累积的技术优势,但是别人在追赶它的时候,能看见它已经成功做了什么,那么(追赶)就会更容易」,西湖大学张岳教授对机器之心解释。

面壁智能 CTO 曾国洋则进一步表示,从目前公开资料所披露的 GPT-4的具体技术情况,我们发现它并没有使用一些特别神奇、超越时代的科技,本质上也是用大家都能理解的技术来做拼接组合,最终实现了效果更好。

如果说,领先的闭源模型是确定可追随的,那么意味着,「长远来看,闭源大模型并没有真正的护城河」,曾国洋与张岳认为。

在这个前提下,追随者之中,开源AI无疑是最有竞争力的一支力量。在开源社区的支持下,开源模型的迭代速度比想象地更快。以 Llama2本身所欠缺的中文语料为例,仅在 Meta 开源 Llama2次日,开源社区首个能下载、能运行的开源中文 Llama2模型「Chinese Llama27B」就出现了。

在商业环境中,一家基于开源模型研发的的垂直 AIGC 产品公司近日告诉机器之心,经过它们的内部验证,任何闭源模型的更新,它们有信心能够结合自身的数据和工程化经验,三个月内在自己垂直的场景中实现差不多的水平。

当然,短期来看领先的闭源模型相较于开源模型,护城河仍然十分清晰。东北大学教授肖桐认为,相较于开源模型,走闭源路线的大厂在人才、组织以及数据三个方面有短时间难以取代的优势。大厂往往拥有更高密度更高水平的人才,以及有经验的团队能够协调人才和高性能设备,并且能够拥有其他人无法拿到数据。此外,曾国洋还提到,大厂往往也拥有充足算力。「但长期来说的话,数据和算力各种要素都会慢慢追平」。

在这个过程中,开源模型真正的影响力在于对生态系统的构建。「Llama2可能会推动大模型上下游进行整合,一旦解决了规模的问题,成本也将大大下降」,肖桐表示。

虽然目前 Llama2仅仅可能是大模型开源生态系统的开端,「大家对 Llama2的能力边界不是非常清晰,生态系统的形成同样需要一些时间」。但随着 Llama2的释出,开源社区的技术能力被带上另一个台阶,大模型开源社区的力量已经无法被忽视。

更新于:2023-08-20 14:11